Search Console一括データエクスポート設定マニュアル

すぐに、Search Console一括データエクスポート設定方法を見たい方は、目次からSearch Console一括データエクスポート設定方法をクリックしてください。Search Console一括エクスポートとBigQueryの知識を得てから進みたい方は、このまま最初からお読みください。

Search Console一括データエクスポートとは

Search Consoleのパフォーマンスデータを、自動的に「BigQuery」に毎日エクスポートする機能です。

BigQueryとは

Google Cloudのクラウド型データウェアハウスで、管理が非常に楽なサーバーレス仕様となっています。操作が簡単・コストパフォーマンスが高い・レスポンスが高速 と使い勝手のよいのが特徴です。

用途としては、GA4、Search Console、ECデータ、交通情報などのビッグデータ分析に向いています。

BigQueryの料金:

BigQueryの利用には「ストレージ料金」「クエリ(分析)」の2通りの料金がかかります。ただし、毎月無料枠が設けられていますので相当大きなデータを処理しない限りは無料枠で収まるでしょう。

| リソース | 無料枠 |

|---|---|

| ストレージ | 10GBまで無料 |

| クエリ(分析) | 処理データ1TBまで無料 |

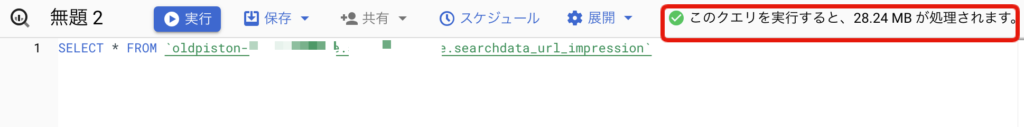

BigQuery料金目安:

Search Consoleデータ60日分のクエリ18万行を全列読み込んでみたところ、処理に30MB弱ほどかかりました。毎日30MBを読み込んだ場合、900MBのクエリ処理となります。1TBまで無料枠があるので0.1%の利用で収まります。

Search Console一括データエクスポート設定方法

もし、Google Cloud Platform(GCP)を使ったことのない方は、Google Cloud登録から始める必要があります。

Google Cloudアカウント登録

- Google Cloud Platformにアクセスし、「無料で開始」をクリックします。

- 必要な情報を入力してアカウントを設定します。

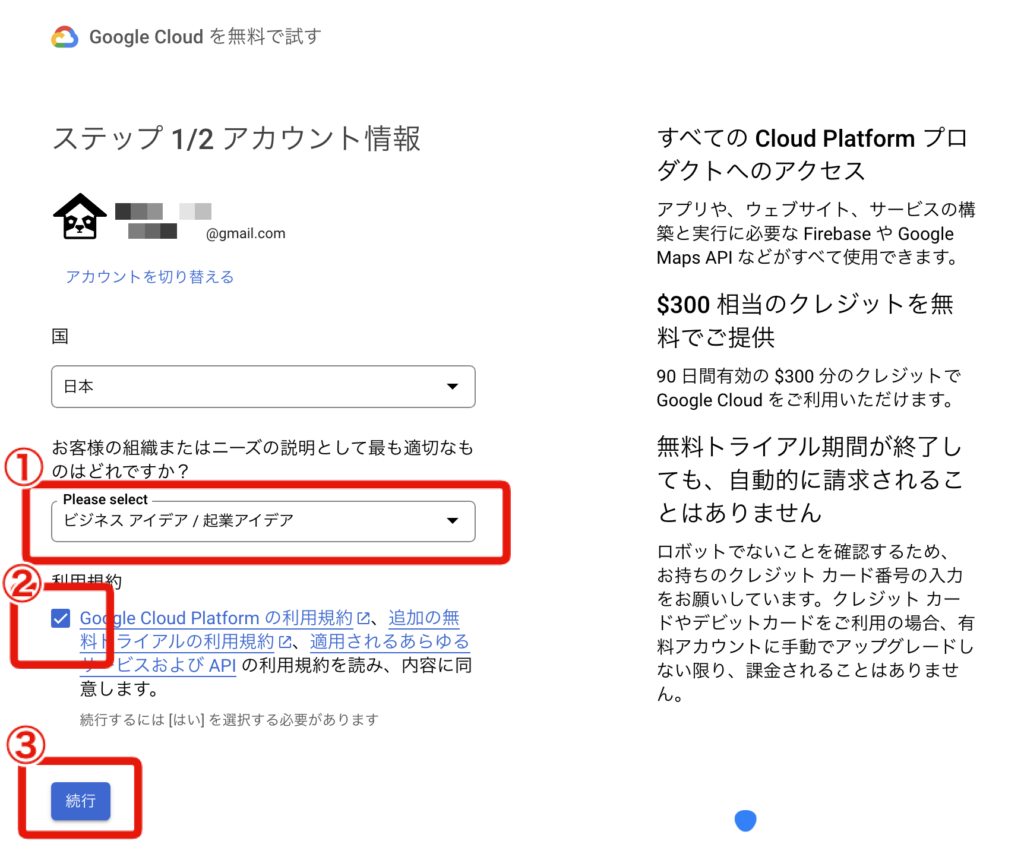

Google Cloudアカウント登録:

下画像のとおりに進めて登録を完了させます。支払い情報が必要ですのでクレジットカードをご準備ください。

- 該当する組織を選択

- 利用規約にチェック

- 続行ボタン押す

- 支払い方法にクレジットカード情報を入力

- 無料トライアルを開始ボタンを押す

Cloud プロジェクトを準備する

プロジェクトの選択を押して、Cloudプロジェクト選択画面を開きます。

プロジェクト名は、わかりやすい名前(英数字)にしましょう。場所は、組織なし(デフォルトのまま)でOKです。

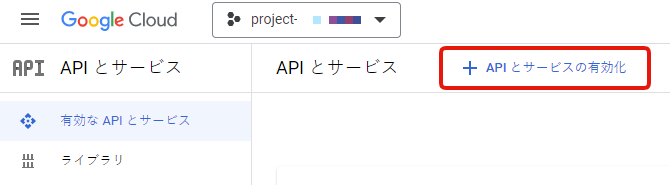

BigQueryを有効にする

Google Cloudの左メニューを開いて、APIとサービスを選択します。

+APIとサービスの有効化を選択します。

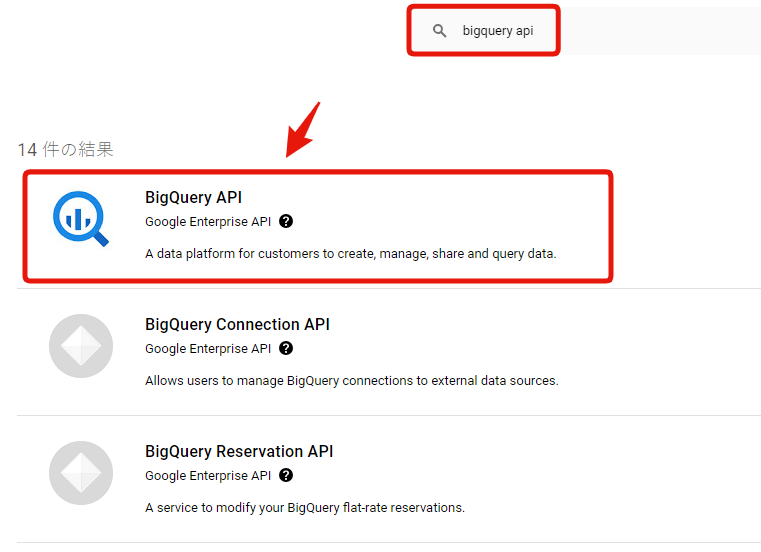

検索窓に「bigquery api」と入力して、検索結果に表示されたBigQuery APIを選択します。

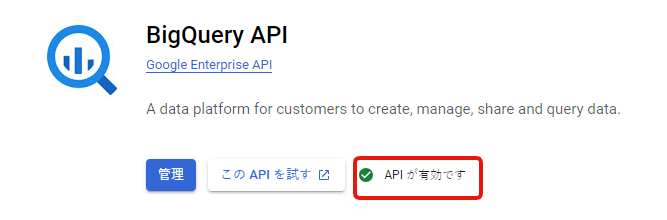

BigQuery APIを有効化します。

Google Cloudでの権限付与

- Google Cloudにて、対象のプロジェクトを選択します。

- サイドバーで「IAMと管理」を選択します。

- 「+ アクセス権を付与」をクリックして、新しいメンバーを追加します。

- メンバー名として

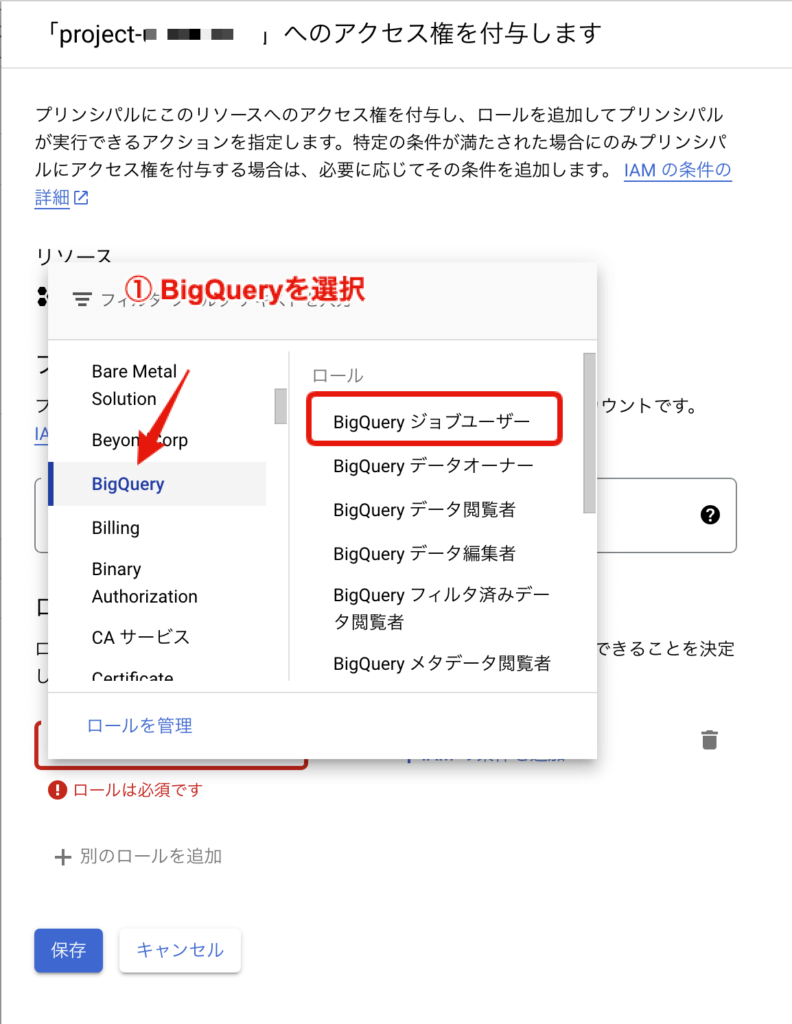

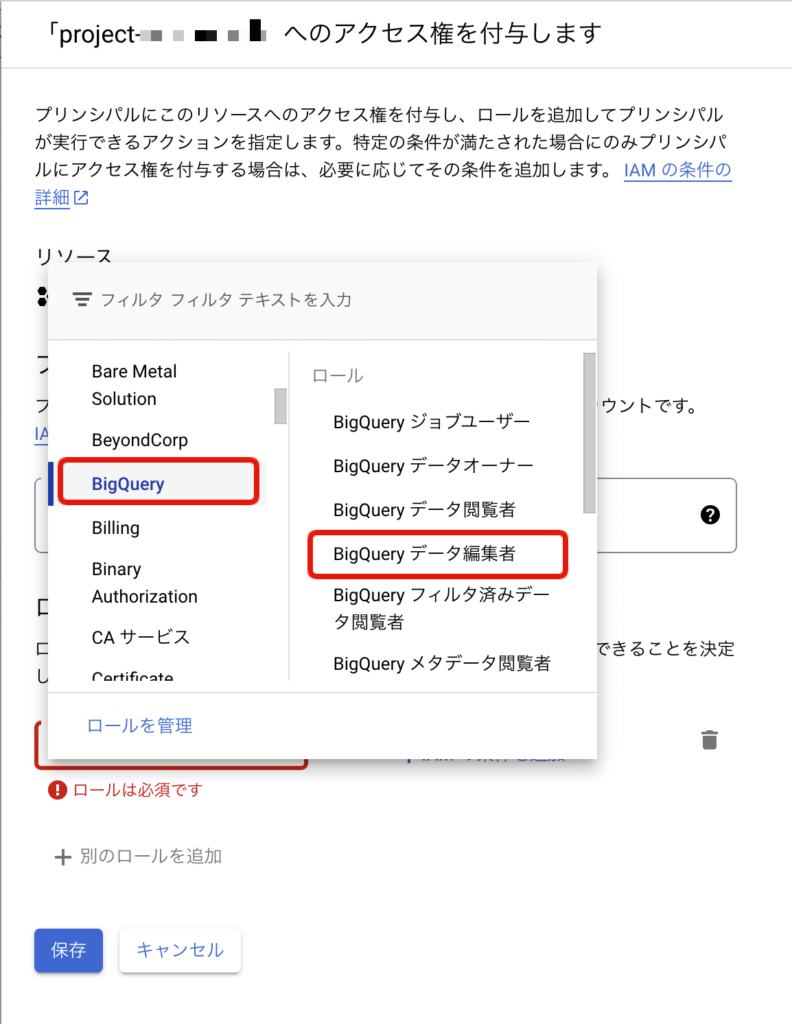

search-console-data-export@system.gserviceaccount.comを新しいプリンシパル欄に入力します。 - 「BigQuery ジョブユーザー」と「BigQuery データ編集者」の2つのロールを付与します。(下画像参照)

- 「保存」をクリックして権限を適用します。

Search Consoleで一括エクスポートを有効にする

BigQueryの設定と権限設定が完了した後、Google Search Consoleで一括エクスポートを開始する手順は以下の通りです。

- Cloudプロジェクトを入力

- データセットの場所を東京にセット

Search Console での操作:

一括データエクスポート

https://search.google.com/search-console/settings/bulk-data-export

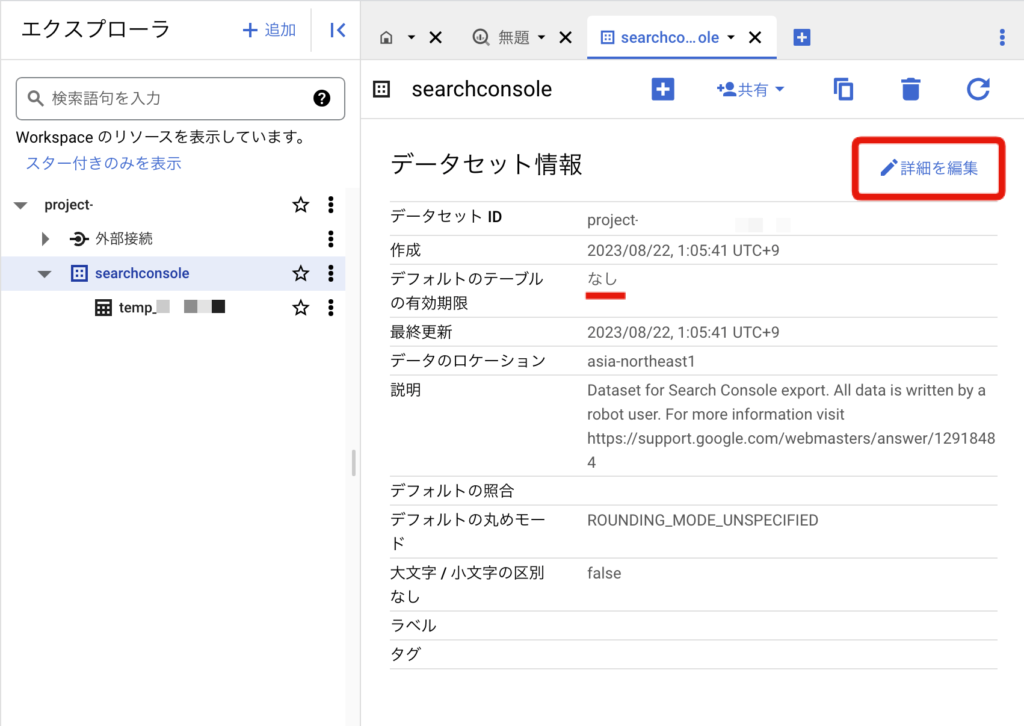

テーブルの有効期間を設定する

デフォルトのテーブルの有効期限を設定します。利用するシステムが保持する日数によって調整してください。SEOオーランの場合は、2ヶ月なので62日推奨。

テーブルの有効期限を設定しないと、Search Consoleデータが日々増え続けて、データ処理に時間がかかるようになりますし、無料枠を超える可能性が出てきますので必ず行いましょう。

Search Console連携を行ってから自動的にデータが入ってくるまで、48時間ほどかかります。